L’humanité en mode bêta : le grand laboratoire de l’IA

L’illusion du produit fini : l’ère du « bêta perpétuel »

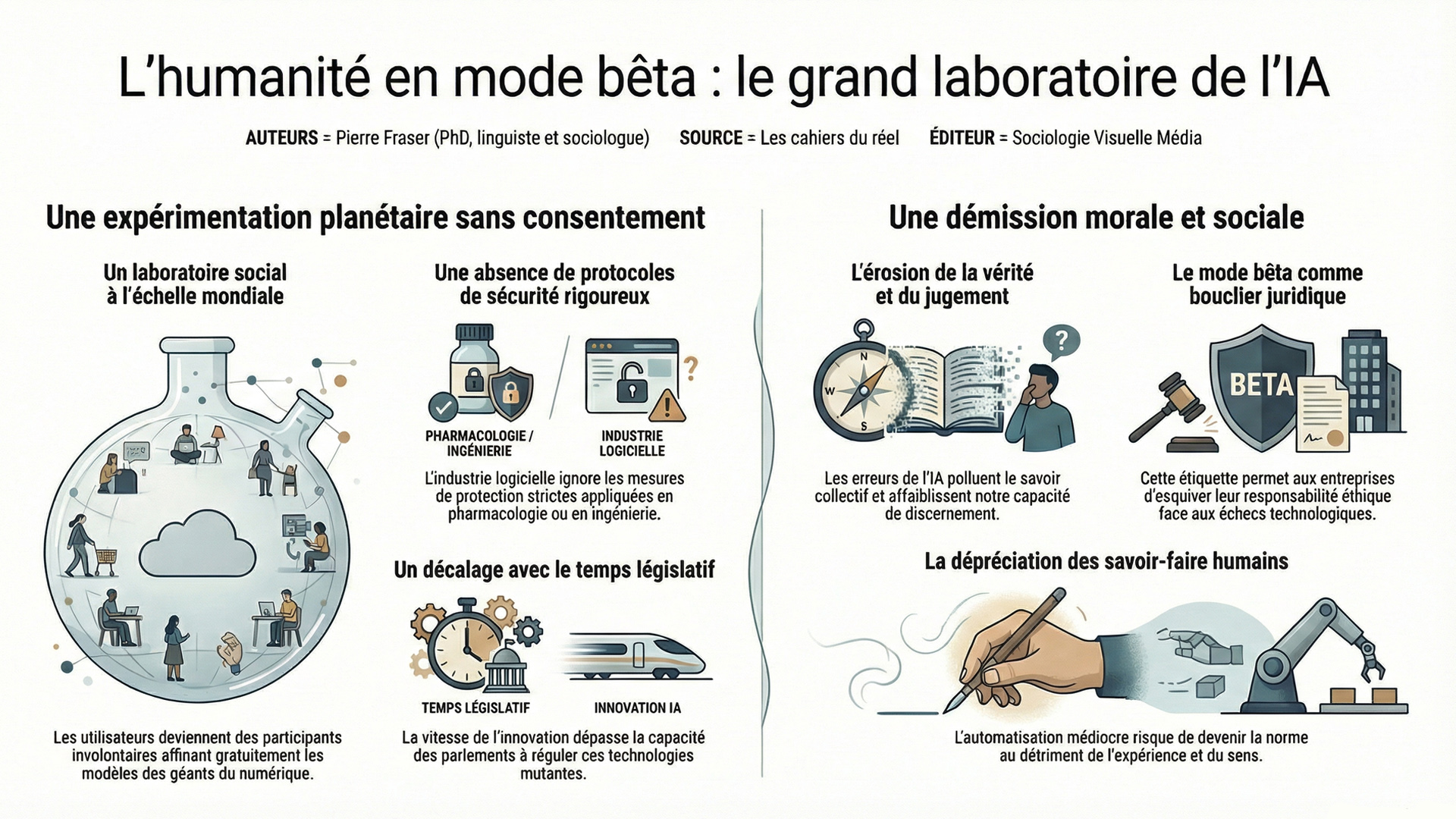

L’industrie technologique a opéré un basculement paradigmatique en imposant le concept de « bêta perpétuel » comme nouvelle norme de consommation. Contrairement au secteur de l’ingénierie civile ou de la pharmacologie, où l’on n’imaginerait jamais livrer un pont ou un vaccin sans des protocoles de sécurité draconiens, l’IA se déploie sans filet. La version préliminaire permanente devient la structure même du produit. On vend aujourd’hui des promesses de futur pour masquer les lacunes du présent, transformant chaque erreur algorithmique en une simple étape de développement plutôt qu’en une faute professionnelle.

Conséquemment, nous ne sommes plus de simples clients, mais les rouages essentiels d’une expérience sociologique à l’échelle planétaire dont personne n’a signé le formulaire de consentement éclairé. Chaque interaction avec une interface d’IA générative nourrit la machine où des milliards d’individus corrigent, affinent et entraînent gratuitement les modèles de langage des géants de la Silicon Valley au fil de leurs requêtes quotidiennes. C’est une forme d’externalisation massive de la recherche et développement. Le monde entier est devenu un tube à essai géant, où la frontière entre le domicile privé et le laboratoire informatique s’est définitivement évaporée sous la pression du progrès technique.

Tout ceci a un impact certain, car la vélocité de l’innovation logicielle crée un décalage abyssal avec la lenteur nécessaire des processus législatifs. Les parlements tentent de réguler des technologies qui ont déjà muté plusieurs fois avant même que le premier article de loi ne soit voté. Ce déséquilibre flagrant offre dès lors aux entreprises une liberté de mouvement quasi totale, leur permettant d’occuper le terrain médiatique et économique sans réelle opposition ; c’est le règne du fait accompli. Face à l’inertie des États, les géants du Web imposent leurs propres règles éthiques, souvent malléables et subordonnées aux impératifs de croissance.

L’érosion de la vérité et la fragilité sociale à l’ère de l’IA

Le déploiement prématuré de ces systèmes entraîne aussi des conséquences tangibles qui dépassent le simple cadre technique pour toucher à la structure même de nos sociétés. Les hallucinations de l’IA, autrefois de simples curiosités amusantes, polluent désormais les bases de connaissances collectives et favorisent une désinformation d’une précision redoutable. Le risque de fragmentation sociale est réel, puisqu’en déléguant notre discernement à des algorithmes dont nous ne comprenons pas les biais profonds, nous affaiblissons notre capacité de jugement critique. La stabilité du débat public est ainsi mise à l’épreuve par des outils qui privilégient la cohérence de la forme sur la véracité du fond.

Autrement, l’intégration de l’IA dans des secteurs vitaux comme la santé ou la justice soulève une question éthique fondamentale sur la responsabilité des dirigeants technologiques. Peut-on moralement confier des décisions de vie ou de mort à des systèmes dont on admet, par l’étiquette « bêta », qu’ils ne sont pas totalement fiables ? La course à la domination commerciale semble avoir anesthésié la prudence élémentaire. En acceptant l’alibi de l’expérimentation constante, les entreprises se dédouanent ainsi de leurs propres échecs futurs par une démission morale qui consacre la victoire de l’agilité logicielle sur la sécurité humaine, scellant ainsi un compromis risqué dont les générations futures devront probablement payer le prix.

Nous vivons une époque paradoxale. D’un côté, l’intelligence artificielle pulvérise nos limites biologiques et promet de résoudre les plus grands défis de l’humanité. De l’autre, elle installe une atrophie cognitive silencieuse et un contrôle social sans précédent.

Dans cet essai lucide et provocateur, le sociologue et linguiste Pierre Fraser analyse la trajectoire de l’IA non pas comme un simple outil, mais comme un fétiche moderne qui redéfinit notre rapport au savoir, à la justice et à la vérité. En s’appuyant sur une matrice analytique où la sagesse côtoie la folie, il nous interroge : que reste-t-il de l’humain quand l’algorithme prétend absorber la nuance et la morale ?

L’éthique du cobaye : une démission morale sous couvert d’innovation

La généralisation du mode bêta dans les secteurs régaliens de l’État marque une rupture profonde avec l’éthique de la responsabilité. En introduisant des systèmes probabilistes dans les diagnostics médicaux ou les prédictions judiciaires, les entreprises de la Big Tech transfèrent le risque de l’ingénieur vers l’usager. Le contrat social s’en trouve ainsi vicié puisqu’on ne peut décemment invoquer le droit à l’erreur informatique lorsque celle-ci impacte l’intégrité physique ou la liberté d’un individu.

On peut don considérer que l’alibi de l’expérimentation constante sert ici de bouclier juridique et moral contre les conséquences de l’immaturité technologique. Il s’agit là d’une stratégie de l’esquive : en étiquetant leurs services comme étant « en cours de développement », les géants du numérique s’octroient une impunité de fait, transformant les victimes de biais algorithmiques en de simples « données aberrantes » nécessaires à l’optimisation de la version suivante. À notre avis, cette vision purement utilitariste sacrifie le présent sur l’autel d’une perfection logicielle hypothétique.

Le travail en mode bêta : vers une obsolescence programmée des compétences

Il va également sans dire que l’onde de choc de cette expérimentation massive frappe de plein fouet le marché de l’emploi, créant une instabilité chronique pour les travailleurs du savoir. L’IA n’est pas un outil que l’on maîtrise, mais une cible mouvante qui redéfinit les qualifications nécessaires chaque semestre. En fait, cette instabilité permanente génère une anxiété sourde au sein des entreprises au sein desquelles les salariés se retrouvent contraints d’apprendre à collaborer avec des systèmes dont ils ignorent les mécanismes internes et dont la fiabilité fluctue au gré des mises à jour invisibles.

Cette dynamique fragilise la valeur de l’expérience humaine. Si une machine « imparfaite » peut produire un résultat jugé « suffisant » pour une fraction du coût, la médiocrité automatisée risque de devenir la nouvelle norme de production. On assiste à une dépossession des savoir-faire artisanaux et intellectuels. Le travailleur devient un simple superviseur d’une boîte noire, un correcteur de brouillons générés par une entité qui ne comprend pas ce qu’elle écrit, mais qui le fait avec une rapidité déconcertante. C’est le paradoxe du progrès : nous gagnons en vitesse ce que nous perdons en maîtrise et en sens. La parade se trouve peut-être ici, dans le fait d’utiliser l’IA comme un allié qui oblige à se confronter à soi-même.

Cette démission morale, où l’agilité logicielle supplante la sécurité humaine, n’est que le prélude d’un basculement plus vaste dont nous commençons à peine à percevoir l’onde de choc. Pour comprendre comment ce mode « bêta » généralisé prépare le terrain à une fusion totale entre nos structures sociales et l’algorithme, je vous invite à prolonger cette réflexion dans mon dernier essai : « Singularité technologique : quand l’IA absorbe tout, même le social ». Dans cet ouvrage, j’explore les mécanismes profonds de cette absorption et les voies de résistance qui nous restent pour préserver l’essence de notre humanité face à l’hégémonie de la machine.

[Découvrir l’ouvrage et se le procurer ici]

© Pierre Fraser (PhD, linguiste et sociologue) + Sociologie Visuelle Média, 2026